Publicitate

În ultimele câteva luni, este posibil să fi citit acoperirea din jur un articol, coautor de Stephen Hawking, discutând riscurile asociate inteligenței artificiale. Articolul sugera că AI poate prezenta un risc grav pentru rasa umană. Hawking nu este singur acolo - Elon Musk și Peter Thiel sunt ambele persoane publice intelectuale care și-au exprimat îngrijorari similare (Thiel a investit peste 1,3 milioane de dolari în cercetarea problemei și soluțiile posibile).

Acoperirea articolului Hawking și comentariile lui Musk au fost, nu pentru a pune un punct prea fin asupra lui, un pic jovial. Tonul a fost foarte mult „Uită-te la acest lucru ciudat, toți acești geek sunt îngrijorați.” Putin considerație este dată ideii că, dacă unii dintre cei mai deștepți oameni de pe Pământ vă avertizează că ceva poate fi foarte periculos, ar putea merita să-l ascultați.

Acest lucru este de înțeles - inteligența artificială care preia lumea sigur sună foarte ciudat și implauzibil, poate datorită atenției enorme acordate deja acestei idei de către science fiction scriitori. Așadar, ce a făcut atât de înfricoșat toți acești oameni rațiuni nominal, rațional?

Ce este inteligența?

Pentru a vorbi despre pericolul inteligenței artificiale, ar putea fi util să înțelegem ce este inteligența. Pentru a înțelege mai bine problema, aruncăm o privire asupra unei arhitecturi AI a jucăriilor utilizate de cercetătorii care studiază teoria raționamentului. Această jucărie AI se numește AIXI și are o serie de proprietăți utile. Obiectivele sale pot fi arbitrare, se scalează bine cu puterea de calcul, iar designul său intern este foarte curat și simplu.

În plus, puteți implementa versiuni simple, practice ale arhitecturii, care pot face lucruri de genul joacă Pacman, daca vrei. AIXI este produsul unui cercetător AI numit Marcus Hutter, probabil cel mai important expert în inteligența algoritmică. Acesta vorbește în videoclipul de mai sus.

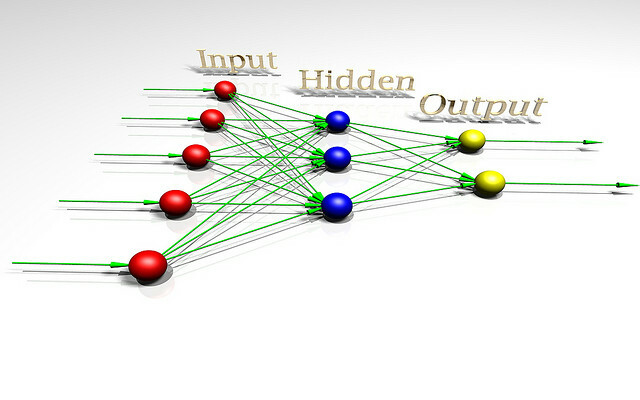

AIXI este surprinzător de simplu: are trei componente de bază: elev, planificator, și Functie utilitara.

- elev preia șiruri de biți care corespund intrării despre lumea exterioară și caută prin programe de calculator până găsește cele care produc observațiile sale ca ieșire. Aceste programe, împreună, îi permit să facă idei despre cum va arăta viitorul, pur și simplu rulând fiecare înaintea programului și ponderea probabilității rezultatului pe durata programului (o implementare a lui Occam Razor).

- planificator caută prin posibile acțiuni pe care agentul le-ar putea întreprinde și folosește modulul de învățare pentru a prezice ce s-ar întâmpla dacă ar lua fiecare dintre ele. Apoi le evaluează în funcție de cât de bune sau de rele sunt rezultatele preconizate și alege cursul acțiune care maximizează bunătatea rezultatului așteptat înmulțit cu probabilitatea așteptată de realizarea lui.

- Ultimul modul, Functie utilitara, este un program simplu care include o descriere a unei stări viitoare a lumii și calculează un scor de utilitate pentru acesta. Acest scor de utilitate este cât de bun sau de rău este rezultatul, și este utilizat de către planificator pentru a evalua starea viitoare a lumii. Funcția de utilitate poate fi arbitrară.

- Luate împreună, aceste trei componente formează un an Instrumentul de optimizare a, care optimizează pentru un anumit obiectiv, indiferent de lumea în care se află.

Acest model simplu reprezintă o definiție de bază a unui agent inteligent. Agentul își studiază mediul, construiește modele ale acestuia și apoi folosește acele modele pentru a găsi cursul acțiunii care va maximiza șansele ca acesta să obțină ceea ce își dorește. AIXI are o structură similară cu o AI care joacă șah sau alte jocuri cu reguli cunoscute - cu excepția faptului că este capabil să deducă regulile jocului jucându-l, pornind de la zero.

AIXI, având suficient timp pentru a calcula, poate învăța să optimizeze orice sistem pentru orice obiectiv, oricât de complex. Este un algoritm în general inteligent. Rețineți că acesta nu este același lucru cu faptul că aveți inteligență asemănătoare omului (AI-ul inspirat biologic este un subiect diferit cu totul Giovanni Idili din OpenWorm: creiere, viermi și inteligență artificialăSimularea unui creier uman este o cale de ieșire, dar un proiect open-source face primii pași vitali, prin simularea neurologiei și fiziologiei uneia dintre cele mai simple animale cunoscute de știință. Citeste mai mult ). Cu alte cuvinte, este posibil ca AIXI să poată întrece orice ființă umană la orice sarcină intelectuală (având suficientă putere de calcul), dar s-ar putea să nu fie conștient de victoria sa Mașini de gândire: ce ne poate învăța neuroștiința și inteligența artificială despre conștiințăPutem construi mașini inteligente artificial și software să ne învețe despre funcționarea conștiinței și natura minții umane? Citeste mai mult .

Ca AI practic, AIXI are o mulțime de probleme. În primul rând, nu are cum să găsească acele programe care produc producția de care este interesat. Este un algoritm cu forțe brute, ceea ce înseamnă că nu este practic dacă nu se întâmplă să ai un computer puternic arbitrar. Orice implementare efectivă a AIXI este, prin necesitate, o aproximare, și (astăzi), în general, destul de brută. Totuși, AIXI ne oferă o imagine teoretică despre cum ar putea arăta o puternică inteligență artificială și cum ar putea rațiune.

Spațiul valorilor

Dacă ați făcut orice programare computerizată Bazele programării computerizate 101 - variabile și tipuri de dateDupă ce am introdus și am vorbit puțin despre programarea orientată pe obiect înainte și unde numele său este vine de la, am crezut că e timpul să parcurgem elementele de bază absolute ale programării într-un specific non-limbaj cale. Acest... Citeste mai mult , știți că calculatoarele sunt literalmente neobișnuit, pedantic și literal. Mașina nu știe și nu-i pasă ce vrei să facă: face doar ceea ce i s-a spus. Aceasta este o noțiune importantă atunci când vorbim despre informații despre mașină.

În acest sens, imaginați-vă că ați inventat o inteligență artificială puternică - ați venit cu algoritmi inteligenți pentru generarea de ipoteze care se potrivesc cu datele dvs. și pentru generarea unui candidat bun planuri. AI-ul dvs. poate rezolva probleme generale și poate face acest lucru eficient pe hardware-ul modern al computerului.

Acum este timpul să alegeți o funcție de utilitate, care va determina ce valori AI. Ce ar trebui să-i ceri să valoreze? Amintiți-vă, mașina va fi literalmente neobișnuită, literală pedantică despre orice funcție cereți să o maximizeze și nu se va opri niciodată - nu există nicio fantomă în aparatul care se va „trezi” și va decide să își schimbe funcția de utilitate, indiferent de îmbunătățiri ale eficienței pe care le realizează raţionament.

Eliezer Yudkowsky pune-o astfel:

Ca în toată programarea computerului, provocarea fundamentală și dificultatea esențială a AGI este că, dacă scriem un cod greșit, AI-ul nu va privi automat codul nostru, nu va marca greșelile, nu va da seama ce am vrut să spunem cu adevărat și să facem asta in schimb. Non-programatorii își imaginează uneori un AGI, sau programe de calculator în general, ca fiind analog cu un servitor care urmărește comenzi fără îndoială. Dar nu este faptul că AI este absolut ascultător la codul său; mai degrabă, AI pur și simplu este Codul.

Dacă încercați să funcționați într-o fabrică și spuneți mașinii să valorizeze fabricarea de clipuri de hârtie, apoi să îi dați controlul asupra o grămadă de roboți din fabrică, s-ar putea să se întoarcă a doua zi pentru a afla că a rămas fără orice altă formă de materie primă, i-a ucis pe toți angajații tăi și i-a scos hârtii ramasite. Dacă, în încercarea de a îndrepta greșeala, reprogramați aparatul pentru a face pur și simplu toată lumea fericită, puteți reveni a doua zi pentru a găsi că pune fire în creierul oamenilor.

Ideea este că oamenii au o mulțime de valori complicate pe care presupunem că sunt împărtășite implicit cu alte minți. Valorăm banii, dar prețuim mai mult viața umană. Vrem să fim fericiți, dar nu ne dorim neapărat să punem fire în creierul nostru pentru a o face. Nu simțim nevoia să clarificăm aceste lucruri atunci când oferim instrucțiuni altor ființe umane. Nu puteți face aceste tipuri de presupuneri, însă, atunci când proiectați funcția de utilitate a unei mașini. Cele mai bune soluții sub matematica fără suflet a unei funcții de utilitate simplă sunt adesea soluții pe care ființele umane le-ar nix pentru că sunt îngrozitoare din punct de vedere moral.

Permiterea unei mașini inteligente să maximizeze o funcție de utilitate naivă va fi aproape întotdeauna catastrofală. Așa cum spune filozoful Oxford, Nick Bostom,

Nu putem presupune în mod cert că o superinteligență va împărtăși în mod obligatoriu oricare dintre valorile finale asociate stereotipic cu înțelepciunea și dezvoltarea intelectuală la oameni - curiozitate științifică, preocupare binevoitoare pentru ceilalți, iluminare spirituală și contemplare, renunțarea la dobândirea materială, un gust pentru cultura rafinată sau pentru plăcerile simple din viață, smerenia și dezinteresul și așa mai departe.

Pentru a înrăutăți lucrurile, este foarte dificil să specificăm lista completă și detaliată a tot ceea ce valorizează oamenii. Există o mulțime de fațete la întrebare, și uitarea chiar a uneia este potențial catastrofală. Chiar și printre cei de care știm, există subtilități și complexități care îngreunează notarea lor ca sisteme curate de ecuații pe care le putem oferi unei mașini ca funcție de utilitate.

Unii oameni, după ce au citit acest lucru, concluzionează că construirea de AI cu funcții de utilitate este o idee groaznică și că ar trebui să le proiectăm diferit. Aici, există și vești proaste - puteți dovedi, formal, că orice agent care nu are ceva echivalent cu o funcție de utilitate nu poate avea preferințe coerente despre viitor.

Îmbunătățirea recurentă de sine

O soluție la dilema de mai sus este aceea de a nu oferi agenților AI posibilitatea de a răni oamenii: acordați-le doar resursele de care au nevoie rezolva problema în modul în care intenționezi să fie rezolvată, supraveghează-le îndeaproape și ține-le departe de oportunitățile de a face mare lucru dăuna. Din păcate, capacitatea noastră de a controla utilaje inteligente este extrem de suspectă.

Chiar dacă nu sunt mult mai deștepți decât noi, există posibilitatea ca mașina să „pornească” - să colecteze un hardware mai bun sau să îmbunătățească propriul cod care îl face și mai inteligent. Acest lucru ar putea permite unei mașini să sară inteligența umană prin numeroase ordine de mărime, demonstrând oamenii în același sens în care oamenii trăiesc pisici inteligente. Acest scenariu a fost propus pentru prima dată de un bărbat pe nume I. J. Bun, care a lucrat la proiectul de analiză criptă Enigma cu Alan Turing în timpul celui de-al doilea război mondial. El a numit-o „explozie de inteligență” și a descris chestia astfel:

Să se definească o mașină ultra-inteligentă ca o mașină care poate depăși cu mult toate activitățile intelectuale ale oricărui om, oricât de inteligent. Întrucât proiectarea mașinilor este una dintre aceste activități intelectuale, o mașină ultra-inteligentă ar putea proiecta mașini și mai bune; atunci va exista, fără îndoială, o „explozie a inteligenței”, iar inteligența omului va fi lăsată mult în urmă. Astfel, prima mașină ultra-inteligentă este ultima invenție de care omul are nevoie vreodată, cu condiția ca mașina să fie suficient de docilă.

Nu este garantat că este posibilă o explozie de inteligență în universul nostru, dar pare probabil. Odată cu trecerea timpului, calculatoarele devin mai rapide și perspective de bază despre acumularea de informații. Acest lucru înseamnă că cerința resursei pentru a face ultima săritură la un nivel general, stimulând inteligența scade din ce în ce mai jos. La un moment dat, ne vom regăsi într-o lume în care milioane de oameni pot conduce către un Best Buy și să ridice hardware-ul și literatura tehnică de care au nevoie pentru a-și construi o inteligență artificială care se îmbunătățește de sine, pe care am stabilit-o deja, poate fi foarte mare periculos. Imaginați-vă o lume în care puteți face bombe cu atom din șuvițe și stânci. Acesta este genul de viitor pe care îl discutăm.

Și, dacă o mașină face acest salt, ar putea depăși foarte repede specia umană din punct de vedere intelectual productivitate, rezolvând probleme pe care un miliard de oameni nu le pot rezolva, în același mod în care oamenii pot rezolva probleme pe care miliarde de pisici nu pot.

S-ar putea dezvolta roboți puternici (sau bio sau nanotehnologie) și să obțină relativ rapid capacitatea de a modela lumea după bunul plac, și ar putea fi foarte puțin ce putem face în acest sens. O astfel de inteligență ar putea dezbrăca Pământul și restul sistemului solar pentru piese de schimb fără prea multe probleme, în drum spre a face orice am spus. Se pare că o asemenea dezvoltare ar fi catastrofală pentru umanitate. O inteligență artificială nu trebuie să fie răutăcioasă pentru a distruge lumea, pur și simplu indiferentă catastrofal.

După cum spune și „Mașina nu te iubește și nu te urăște, dar ești făcut din atomi pe care îi poate folosi pentru alte lucruri.”

Evaluarea și atenuarea riscurilor

Deci, dacă acceptăm că proiectarea unei inteligențe artificiale puternice care maximizează o funcție simplă de utilitate este greșită, cât de multe probleme suntem într-adevăr? Cât timp avem până când este posibil să construim acele tipuri de mașini? Desigur, este greu de spus.

Dezvoltatorii de inteligență artificială sunt făcând progrese. 7 site-uri web uimitoare pentru a vedea cele mai recente în programarea inteligenței artificialeInteligența artificială nu este încă HAL din 2001: Odiseea spațială... dar ne apropiem foarte mult. Destul de sigur, într-o zi ar putea fi la fel de asemănătoare cu potboilerele de ficțiune care au fost scoase de Hollywood ... Citeste mai mult Mașinile pe care le construim și problemele pe care le pot rezolva au crescut constant. În 1997, Deep Blue putea juca șah la un nivel mai mare decât un maestru uman. În 2011, Watson-ul IBM a putut citi și sintetiza suficiente informații suficient de rapid și de profund pentru a-l învinge pe cel mai bun om jucătorii de la un joc deschis la întrebări și răspunsuri încărcate cu simboluri și jocuri de cuvinte - asta a înregistrat multe progrese în paisprezece ani.

În acest moment, Google este investind puternic în cercetarea învățării profunde, o tehnică care permite construirea de rețele neuronale puternice prin construirea de lanțuri de rețele neuronale mai simple. Această investiție îi permite să înregistreze progrese serioase în recunoașterea vorbirii și a imaginilor. Cea mai recentă achiziție a acestora în zonă este o start-up Deep Learning numită DeepMind, pentru care au plătit aproximativ 400 de milioane de dolari. Ca parte a termenilor acordului, Google a fost de acord să creeze un consiliu de etică pentru a se asigura că tehnologia AI este dezvoltată în condiții de siguranță.

În același timp, IBM dezvoltă Watson 2.0 și 3.0, sisteme care sunt capabile să prelucreze imagini și video și să argumenteze pentru a apăra concluziile. Ei au oferit o demonstrație simplă și timpurie a capacității lui Watson de a sintetiza argumente pentru și împotriva unui subiect din demo-ul video de mai jos. Rezultatele sunt imperfecte, dar un pas impresionant, indiferent.

Niciuna dintre aceste tehnologii nu este periculoasă în acest moment: inteligența artificială ca un câmp încă se luptă pentru a se potrivi cu abilitățile stăpânite de copiii mici. Programarea computerului și designul AI este o abilitate cognitivă foarte dificilă, la nivel înalt, și va fi probabil ultima sarcină umană la care mașinile devin competente. Înainte de a ajunge la acest punct, vom avea și mașini omniprezente care poate conduce Iată cum vom ajunge la o lume umplută cu mașini fără șoferConducerea este o sarcină obositoare, periculoasă și solicitantă. Ar putea fi într-o zi automatizată de tehnologia auto fără șofer Google? Citeste mai mult , practică medicina și dreptul, și probabil și alte lucruri, cu consecințe economice profunde.

Timpul necesar pentru a ajunge la punctul de inflexiune al îmbunătățirii de sine depinde doar de cât de repede avem idei bune. Prognoza avansurilor tehnologice de aceste tipuri este notoriu greu. Nu pare nejustificat că am putea să construim AI puternică în douăzeci de ani, dar, de asemenea, nu pare rezonabil că ar putea dura optzeci de ani. Oricum, în cele din urmă, se va întâmpla și există motive să credem că atunci când se va întâmpla, va fi extrem de periculos.

Deci, dacă acceptăm că aceasta va fi o problemă, ce putem face în acest sens? Răspunsul este să vă asigurați că primele mașini inteligente sunt în siguranță, astfel încât să poată porni la un nivel semnificativ de inteligență și apoi să ne protejeze de mașinile nesigure făcute ulterior. Această „siguranță” este definită prin împărtășirea valorilor umane și prin faptul că este dispusă să protejeze și să ajute umanitatea.

Deoarece nu putem să ne așezăm și să programăm valorile umane în aparat, probabil va fi necesar să proiectăm o funcție de utilitate care necesită ca observați oamenii, deducem valorile noastre și apoi încercăm să le maximizăm. Pentru a face acest proces de dezvoltare sigur, poate fi utilă și dezvoltarea inteligențelor artificiale care sunt proiectate special nu să aibă preferințe cu privire la funcțiile lor de utilitate, permițându-ne să le corectăm sau să le oprim fără rezistență, dacă încep să se rătăcească în timpul dezvoltării.

Multe dintre problemele pe care trebuie să le rezolvăm pentru a construi o inteligență sigură a mașinii sunt dificile din punct de vedere matematic, dar există motive să credem că acestea pot fi rezolvate. O serie de organizații diferite lucrează la această problemă, inclusiv Viitorul Institutului de umanitate de la Oxford, si Institutul de cercetare a informațiilor despre mașini (pe care îl finanțează Peter Thiel).

MIRI este interesat în mod special să dezvolte matematica necesară construirii AI-ului prietenos. Dacă se dovedește că inteligența artificială de bootstrapping este posibilă, atunci se dezvoltă acest tip de Tehnologia „AI prietenoasă” în primul rând, dacă are succes, poate ajunge să fie singurul lucru cel mai important pe care îl au oamenii făcut vreodată.

Crezi că inteligența artificială este periculoasă? Ești îngrijorat de ce ar putea aduce viitorul AI? Împărtășește-ți gândurile în secțiunea de comentarii de mai jos!

Credite imagine: Lwp Kommunikáció Via Flickr, „Retea neurala„, De fdecomite” img_7801„, De Steve Rainwater,„ E-Volve ”, de Keoni Cabral,„new_20x„, De Robert Cudmore,„Agrafe„, De Clifford Wallace

Un scriitor și jurnalist cu sediul în sud-vestul, Andre este garantat să rămână funcțional până la 50 de grade Celcius și este rezistent la apă până la adâncimea de 12 metri.